参照:

機械学習。ニューラルネットワーク(パート1):パーセプトロン学習プロセス

機械学習。ニューラルネットワーク(パート2):TensorFlow.jsを使用したOR、XORのモデリング

以前の記事では、元のレイヤーの各ニューロンが前のレイヤーのすべてのニューロンと接続している場合、ニューラルネットワークレイヤーのタイプの1つだけが使用されていました。

たとえば、24x24の白黒画像を処理するには、画像のマトリックス表現を24x24 = 576要素を含むベクトルに変換する必要があります。ご想像のとおり、このような変換では、重要な属性が失われます。軸の垂直方向と水平方向のピクセルの相対位置です。また、ほとんどの場合、画像の左上隅にあるピクセルは、のピクセルに論理的に説明できる影響を与えることはほとんどありません。右下隅。

これらの欠点を解消するために、画像処理には畳み込み層(CNN)が使用されます。

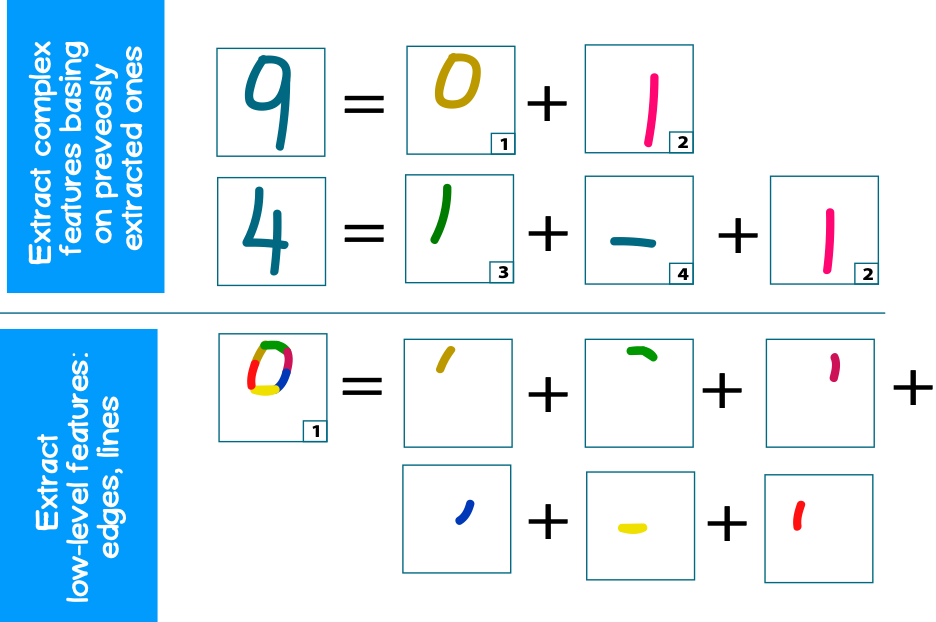

CNNの主な目的は、元の画像から、エッジ、輪郭、円弧、面などのサポート(特性)機能(機能)を含む小さなパーツを抽出することです。次の処理レベルでは、テクスチャのより複雑な繰り返し可能なフラグメント(円、正方形など)をこれらのエッジから認識でき、さらに複雑なテクスチャ(顔の一部、車のホイールなど)に折りたたむことができます。

たとえば、古典的な問題、つまり数字の画像認識について考えてみましょう。それぞれの数字には、それぞれの典型的な数字のセット(円、線)があります。同時に、各円または線は小さなエッジで構成できます(図1)

1. (convolutional layer)

CNN ( ), c () , . – CNN – .

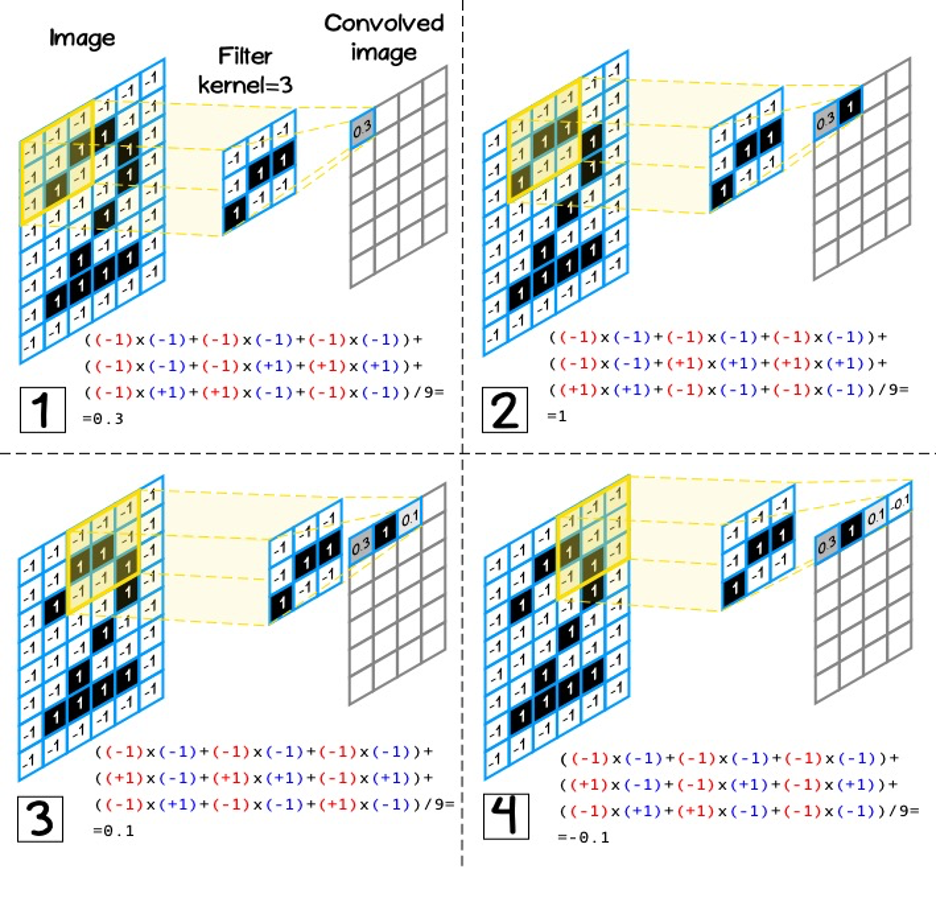

, 2x2 ( K) , 2x2 ( N), :

, .

, (fully-connected, dense layers):

, - , – - , ( ).

2. , , , .

(kernel size) – 3, 5, 7.

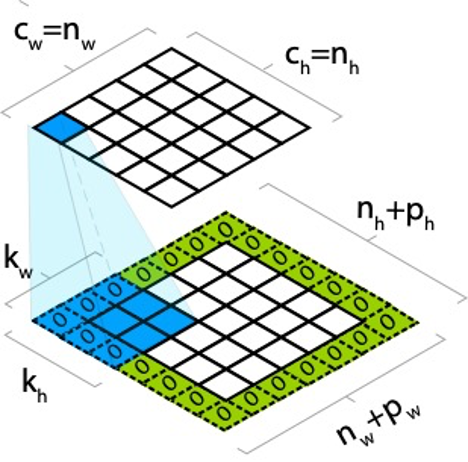

(kernel) [kh, kw], [nh, nw], ( 3):

![3 – [3,3] 3 – [3,3]](https://habrastorage.org/getpro/habr/upload_files/ebc/66a/8ef/ebc66a8ef2e7f8268951b9d3bcaf08ba.png)

, . , . , .

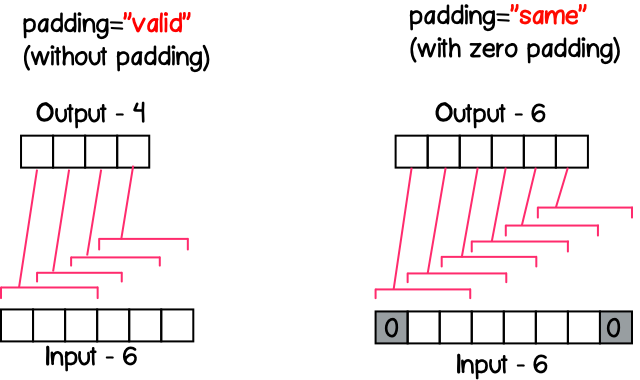

, – (padding). , . , ph pw , :

, , , :

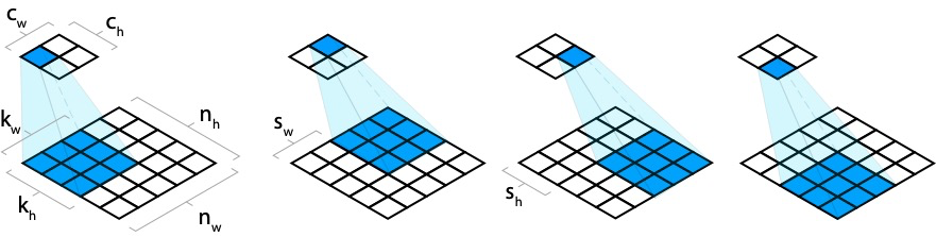

- . , (stride). – (stride).

, sw, sh, :

, ( – ). (). , (CONV1) 9x9x1 ( – - ), 2 1x1 (stride) (padding) , , . 9x9x2 2 – (. 6). CONV2 , , 2x2, , 2, 2x2x2. (CONV2) 9x9x4, 4 – .

, kw kh , nw x nh x nd, nd - , , kw x kh x nd ( 6, CONV2).

7 , RGB, 3x3. , (3 ), 3x3x3.

TensorFlow.js

, : tf.layers.conv2d, – , :

- filter – number –

- kernelSize – number | number[] – , number, , –

- strides – number | number[] - , [1,1], .

- padding – ‘same’, ‘valid’ – , ‘valid’

.

'same'

, , () (stride) . , - 11 , – 5, 13/5=2.6, – 3 ( 8).

stride=1, ( 9), , ( 8).

'valid'

, strides , 8.

TensorFlow.js

, . :

- :

- :

, , tf.browser.fromPixels. , img canvas .

<img src="./sources/itechart.png" alt="Init image" id="target-image"/>

<canvas id="output-image-01"></canvas>

<script>

const imgSource = document.getElementById('target-image');

const image = tf.browser.fromPixels(imgSource, 1);

</script>, , , 3x3, “same” ‘relu’:

const model = tf.sequential({

layers: [

tf.layers.conv2d({

inputShape: image.shape,

filters: 1,

kernelSize: 3,

padding: 'same',

activation: 'relu'

})

]

});[NUM_SAMPLES, WIDTH, HEIGHT,CHANNEL], tf.browser.fromPixel [WIDTH, HEIGHT, CHANNEL], – ( , ):

const input = image.reshape([1].concat(image.shape));. , setWeights Layer, :

model.getLayer(null, 0).setWeights([

tf.tensor([

1, 1, 1,

0, 0, 0,

-1, -1, -1

], [3, 3, 1, 1]),

tf.tensor([0])

]);, , 0-255, NUM_SAMPLES:

const output = model.predict(input);

const max = output.max().arraySync();

const min = output.min().arraySync();

const outputImage = output.reshape(image.shape)

.sub(min)

.div(max - min)

.mul(255)

.cast('int32');canvas, tf.browser.toPixels:

tf.browser.toPixels(outputImage, document.getElementById('output-image-01'));:

2. (pooling layer)

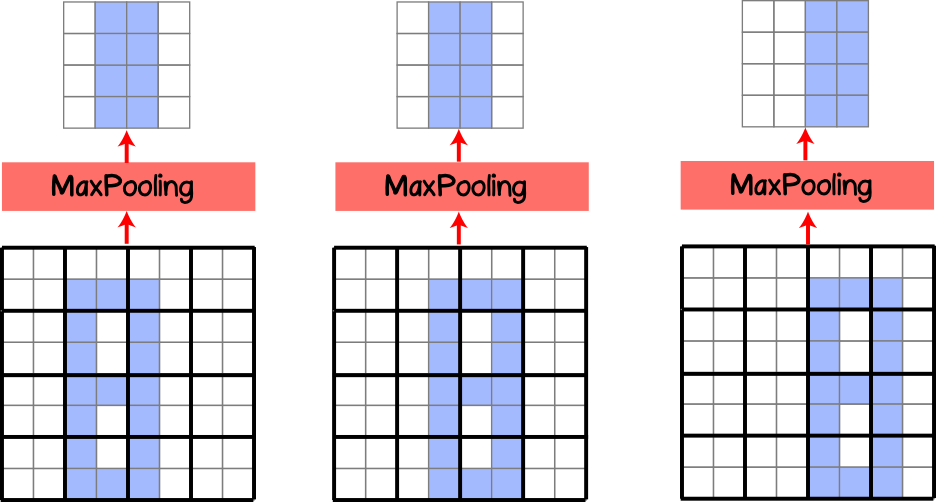

, ( ), , . , , (pooling layer, subsample layer), . MaxPooling .

, .

. (kernel) , (stride) 1x1, . , (. 10).

, 4x4, 2x2 (stride) , 2x2, .

, ( 11) . , , MaxPooling . (translation invariance). , , 50%. , , MaxPooling .

, .

, , – (stride).

MaxPooling AveragePooling, , , . , MaxPooling. AveragePooling , , MaxPooling .

TensorFlow.js (pooling layer)

tf.layers.maxPooling2d tf.layers.averagePooling2d. – , :

-プールサイズ-数| number [] -フィルターの寸法。numberが指定されている場合、フィルターの寸法は正方形になります。配列として指定されている場合、高さと幅が異なる場合があります。

-ストライド-数| number []は順方向ステップであり、オプションのパラメーターであり、デフォルトでは、指定されたpoolSizeと同じ次元になります。

-パディング- '同じ'、 '有効' -ゼロパディングを設定します。デフォルトでは '有効'