AIは署名から画像を生成することを学び、私たちの世界をよりよく理解し始めます

すべての人工知能モデルの中で、一般の人々の想像力を最も捉えたのはOpenAIのGPT-3でした。彼女は、あまりプロンプトを出さずに、詩、短編小説、歌を吐き出すことができ、これらは人の仕事であるとあなたに思わせます。しかし、雄弁さは単なる仕掛けであり、実際の知性と混同しないでください。

ただし、研究者は、GPT-3の作成に使用されたのと同じ手法が、より高度なAIを作成するための秘密を隠していると考えています。GPT-3は、膨大な量のテキスト情報についてトレーニングを受けました。同じテクニックがテキストと画像で同時にトレーニングされた場合はどうなりますか?

Paul Allen Institute for Artificial IntelligenceによるAI2と呼ばれる新しい研究により、このアイデアは次のレベルに引き上げられました。研究者は、特別な視覚言語モデルを作成しました。テキストと画像で機能し、署名から後者を生成できます。画像は不穏で奇妙に見えますが、生成的敵対ネットワーク(GAN)によって作成された超現実的なディープフェイクとはまったく異なります。しかし、彼らはより実用的なインテリジェンスの新しい方向性を示し、おそらくロボットをよりスマートにすることができます。

ギャップを埋める

GPT-3は、「トランスフォーマー」と呼ばれるモデルのグループに属しています。GoogleのアルゴリズムであるBERTの成功のおかげで、最初に人気を博しました。BERTの前は、言語モデルはかなり悪かった。それらの予測能力は、オートコンプリートには十分でしたが、文法規則と常識が守られている長い文を作成するには十分ではありませんでした。

BERTは、マスキングと呼ばれる新しい手法を導入することで状況を変えました(注-元の名前はマスキングです)。これは、異なる単語が文に隠れていることを意味し、モデルはギャップを埋める必要があります。例:

- 女性は練習のために___に行きました。

- 彼らはサンドイッチを作るために___パンを買いました。

モデルにこれらの演習を強制すると、多くの場合100万回、単語が文に組み立てられ、文が段落に組み立てられる方法のパターンが発見され始めるという考え方です。その結果、アルゴリズムはテキストをより適切に生成および解釈し、言語の意味の理解に近づきます。 (Googleは現在BERTを使用して、より関連性の高い検索結果を提供しています。)マスキングが非常に効果的であることが証明された後、研究者は署名の単語を非表示にすることで視覚言語モデルに適用しようとしました。この方法では:

____は木の隣の地面にあります。出典:AI2

今回、モデルは周囲の単語と画像コンテンツを見て、ギャップを埋めることができました。百万回の繰り返しの後、彼女は言葉のパターンだけでなく、言葉と各画像の要素とのつながりも検出することを学びました。

その結果、モデルは、テキストの関係を、赤ちゃんが学習した単語と彼らが見るものとの間の関係をどのように作るかについての視覚的な例にリンクすることができます。モデルは下の写真を撮り、「フィールドホッケーをする女性」などの意味のあるキャプションをまとめることができます。または、「ボール」という単語を写真の円形のオブジェクトに関連付けることで、「ボールは何色ですか」などの質問に答えることができます。

視覚言語モデルは、この写真に意味のあるキャプションを付けることができます:「フィールドホッケーをしている女性」。出典:JOHN TORCASIO / UNSPLASH

一度写真を見た方がいい

研究者たちは、これらのモデルが視覚世界の概念的理解を発展させるかどうかを知りたがっていました。オブジェクトの単語を学んだ子供は、オブジェクト自体がなくても、名前を付けるだけでなく、ヒントに従ってオブジェクトを描くこともできます。そのため、AI2プロジェクトチームは、モデルが同じことを行うことを提案しました。キャプションから画像を生成します。すべてのモデルで意味のないピクセルのゴミが発生しました。

それは鳥ですか?これは飛行機ですか?いいえ、これは人工的な知性によって生成されたぎこちないものです。出典:AI2

これは理にかなっています。テキストを画像に変換することは、その逆を行うよりも困難です。 「署名は、写真のすべてを定義するものではありません」と、AI2のコンピュータービジョンチームリーダーであるAniKembhaviは言います。したがって、モデルは、不足している詳細を追加するために、私たちの世界に関する大量の知識を利用する必要があります。

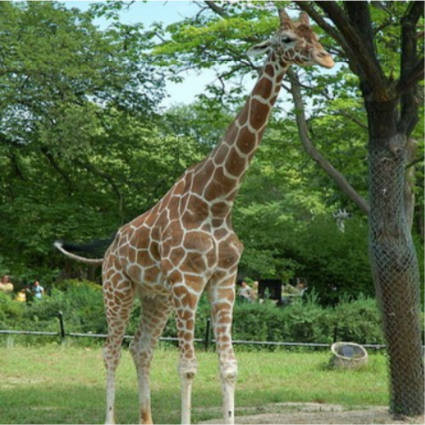

たとえば、モデルが「道を歩いているキリン」を描くように求められた場合、彼女は道が明るいピンクではなく灰色になり、海ではなく畑の隣を通過すると結論付ける必要があります。このすべての情報は明示的ではありませんが。

そこで、ケンバビと彼の同僚であるジェミン・チョ、ジアセン・ルー、ハンナネ・ハジシルジは、マスキングへのアプローチを微調整することで、この隠された視覚的知識をすべてモデルに教えることができるかどうかを確認することにしました。対応する写真のキャプション内の「マスクされた」単語を単純に予測するようにアルゴリズムをトレーニングする代わりに、対応するキャプションに基づいて写真内の「マスクされた」ピクセルを予測するようにアルゴリズムをトレーニングしました。

モデルによって作成された最終的な画像は、完全に現実的ではありません。しかし、それは重要ではありません。それらには、正しい高レベルの視覚的概念が含まれています。 AIは、人を表すためにダッシュスティックを描く子供のように機能します。 (ここでモデルを自分でテストできます)。

キャプションからAI2モデルによって生成されたサンプル画像。出典:AI2

そのような画像を生成する視覚言語モデルの能力は、人工知能研究における重要な前進を表しています。これは、モデルが実際にある程度の抽象化(世界を理解するための基本的なスキル)が可能であることを示唆しています。

長期的には、スキルはロボット工学に重要な影響を与える可能性があります。ロボットが環境をよりよく理解し、言語を使用して環境について通信するほど、実行できるタスクは複雑になります。短期的には、Hajishirzi氏は、視覚化は、現在ブラックボックスのように機能しているモデルが何を学習しているかを研究者がよりよく理解するのに役立つと述べています。

将来的には、チームはさらに実験を行い、画像生成の品質を向上させ、モデルの視覚的および語彙を拡張して、より多くのトピック、オブジェクト、および形容詞を含めることを計画しています。

「画像の作成は本当にパズルの欠けている部分でした」とLuは言います。「それを追加することで、私たちは自分たちの世界をよりよく理解するようにモデルを教えることができます。」