トランスフォーマーベースのモデルは、会話型AI、自然言語処理、画像処理、さらには音楽など、さまざまな分野で優れた結果を達成しています。アーキテクチャの主要コンポーネントは、入力シーケンス内のすべてのペアの類似性を計算するTransformersアテンションモジュール(アテンションモジュール)です。ただし、入力シーケンスの長さの増加に応じて適切にスケーリングできないため、すべての類似性推定値を取得するための計算時間の2次増加、およびこれらの推定値を格納するためのマトリックスの構築に使用されるメモリ量の2次増加が必要です。

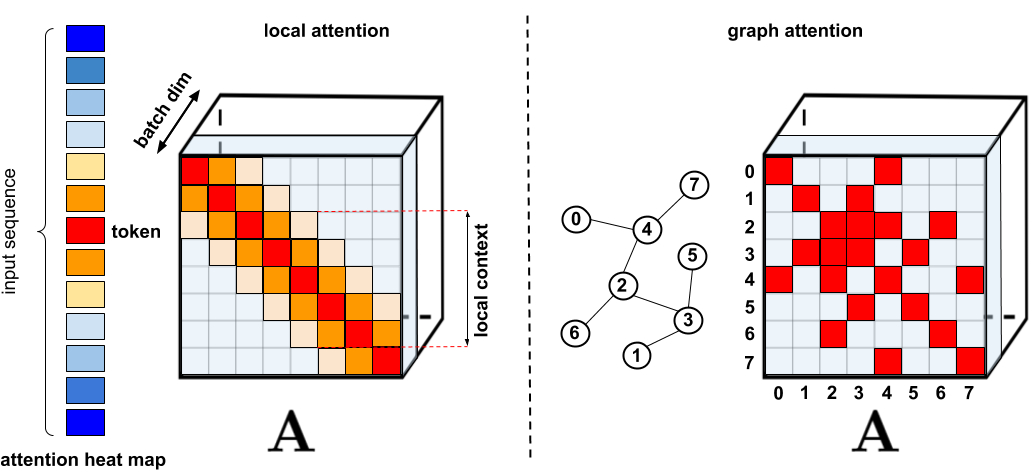

長時間の注意が必要なアプリケーションでは、メモリキャッシング技術など、より高速でコンパクトなプロキシがいくつか提案されていますが、より一般的な解決策は、まばらな注意を使用することです。スパースアテンションは、すべての可能なペアではなく、シーケンスから限られた数の類似性スコアのみを計算することにより、アテンションメカニズムの計算時間とメモリ要件を削減し、完全なマトリックスではなくスパースになります。これらのスパースオカレンスは、スパーストランスフォーマー、ロングフォーマーなどの手法で示されているように、手動で提案、最適化手法を使用して検出、学習、またはランダム化することができます。、ルーティングトランスフォーマー、リフォーマー、ビッグバード。スパースマトリックスはグラフやエッジで表すこともできるため、スパースメソッドは、特にグラフアテンションネットワークで概説されているアテンションメカニズムに関して、グラフニューラルネットワークの文献によっても動機付けられています。このようなスパース性アーキテクチャでは、通常、完全な注意メカニズムを暗黙的に作成するために追加のレイヤーが必要です。

. : , . : Graph Attention Networks, , , . . « : » .

, . (1) , ; (2) ; (3) , , ; (4) , , . , , , Pointer Networks. , , , (softmax), .

, Performer, , . , , , ImageNet64, , PG-19. Performer () , , () . (Fast Attention Via Positive Orthogonal Random Features, FAVOR+), . ( , -). , .

, , , . , - . , , .

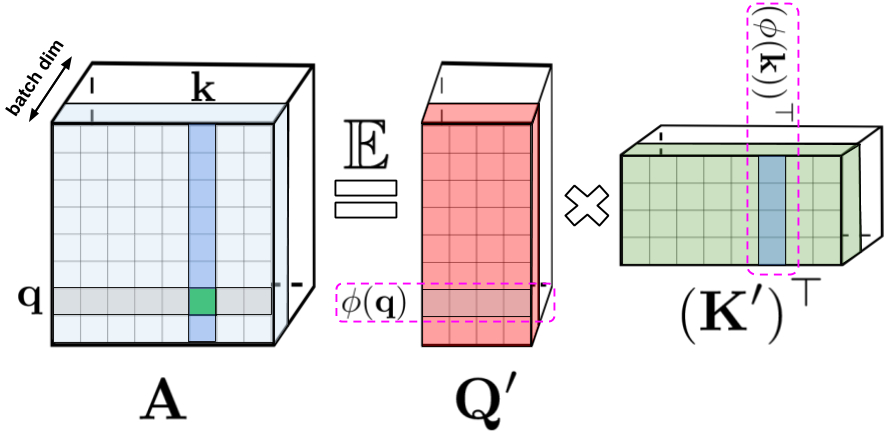

: , , , q k. : Q' K' , /. - , .

- , . , , , () . , . , , .

, , . , , , , -.

FAVOR+:

, . , . , , . , FAVOR+.

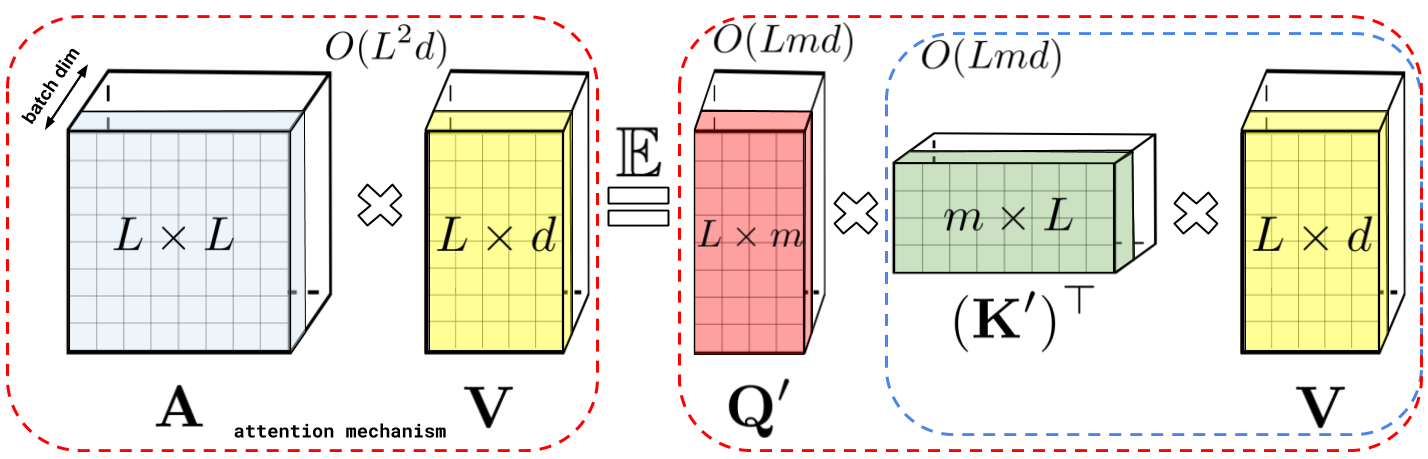

: , A V. : Q' K', A , , , , A .

, , . () , , , , , , .

: , . : , .

Performer , , , .

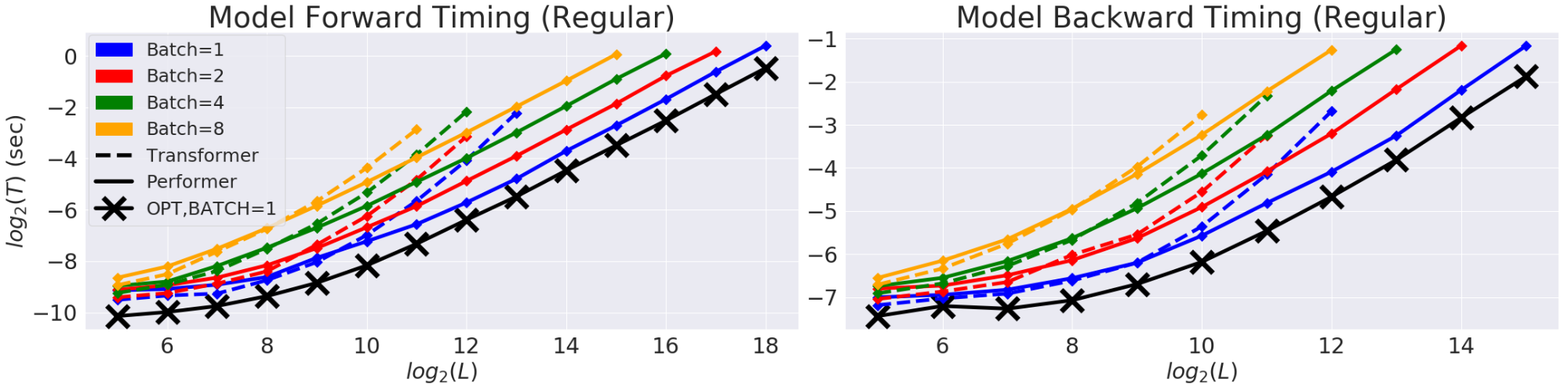

(T) (L). GPU. (X) «» , , , . Performer .

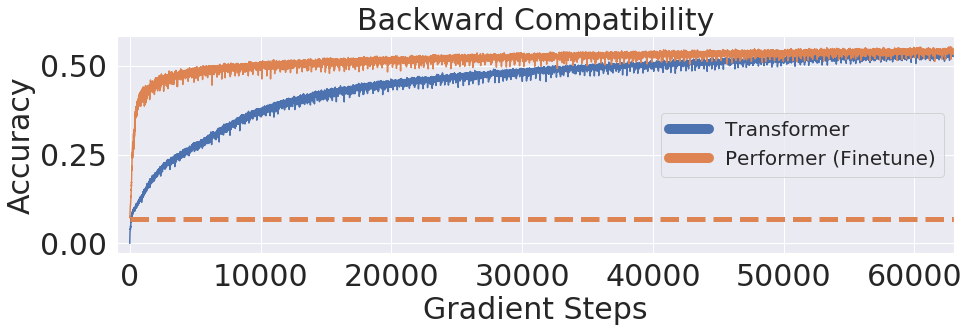

, Performer, -, , .

One Billion Word Benchmark (LM1B), Performer, 0.07 ( ). Performer .

:

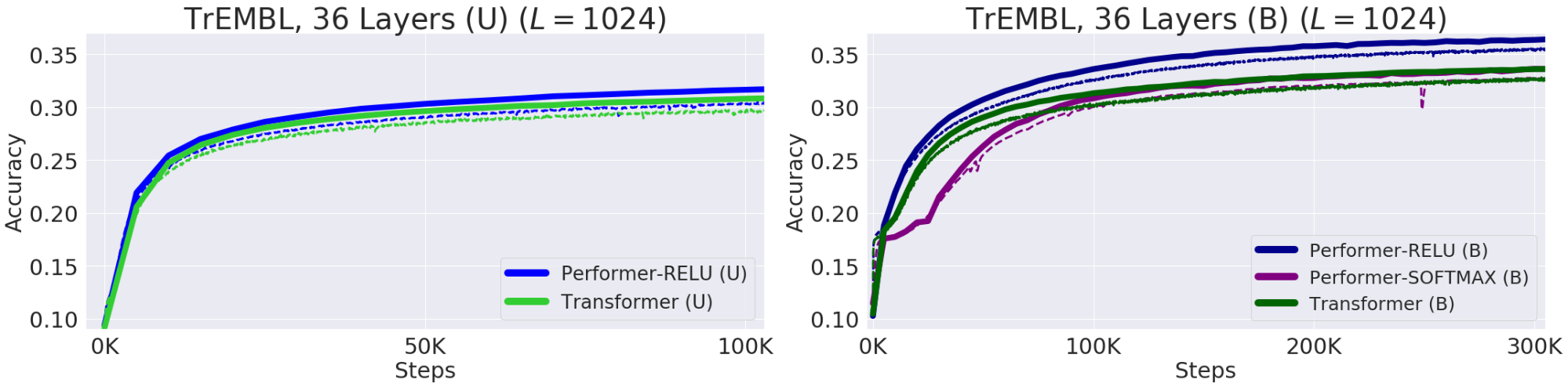

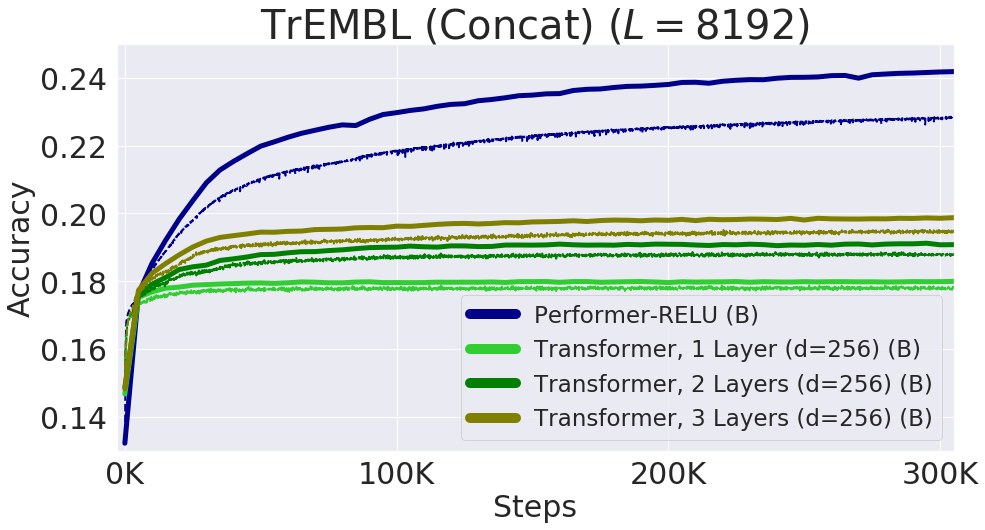

— , . , , 20 . (, UniRef) , . Performer-ReLU ( ReLU, , ) , Performer-Softmax (accuracy) , .

. (Train) — , (Validation) – , — (U), — (B). 36 ProGen (2019) , 16x16 TPU-v2. .

Protein Performer, ReLU. Performer , , . , , . Performer' . , , Performer - .

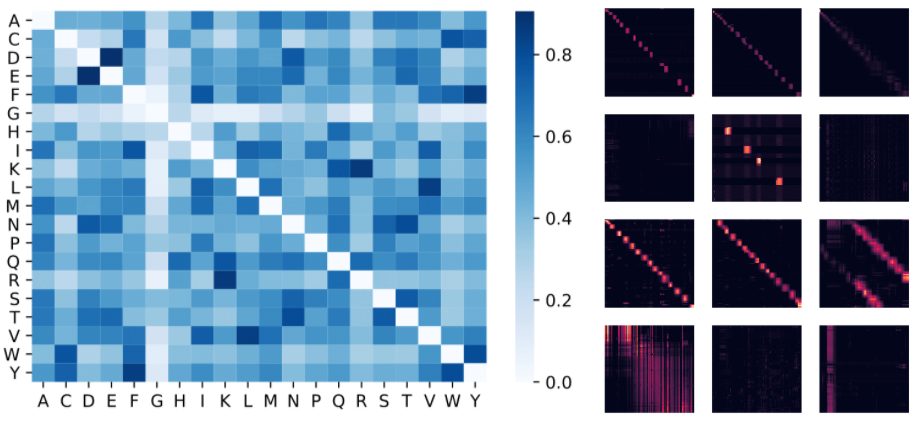

: , . , (D, E) (F, Y), . : 4 () 3 «» () BPT1_BOVIN, .

8192, . TPU, ( ) .

, . , , FAVOR Reformer. , Performer' . , , .

- — Krzysztof Choromanski, Lucy Colwell

- —

- 編集とレイアウト-セルゲイShkarin