仮想現実のリアルタイムレンダリングは、独特のさまざまな課題を生み出します。主な課題は、フォトリアリスティックな効果をサポートし、高解像度を実現し、リフレッシュレートを向上させる必要があることです。これらの課題に対処するために、Facebook Reality Labsの研究者は、2018年12月に導入したレンダリングエンジンであるDeepFocusを開発しました。 AIを使用して、可変焦点長デバイスで超リアルなグラフィックを作成します。今年のSIGGRAPH仮想会議では、この作業のさらなる発展を発表し、VRの将来の高解像度ディスプレイに向けた旅の新たなマイルストーンを開きました。

「リアルタイムレンダリングのためのニューラルスーパーサンプリング」というタイトルのSIGGRAPHの技術記事は、リアルタイムレンダリングのために低解像度の着信画像を高解像度の画像に変換する機械学習ソリューションを提供します。このアップサンプリングプロセスでは、シーン統計でトレーニングされたニューラルネットワークを使用して正確な詳細を復元すると同時に、リアルタイムアプリケーションでそれらの詳細をレンダリングするための計算コストを削減します。

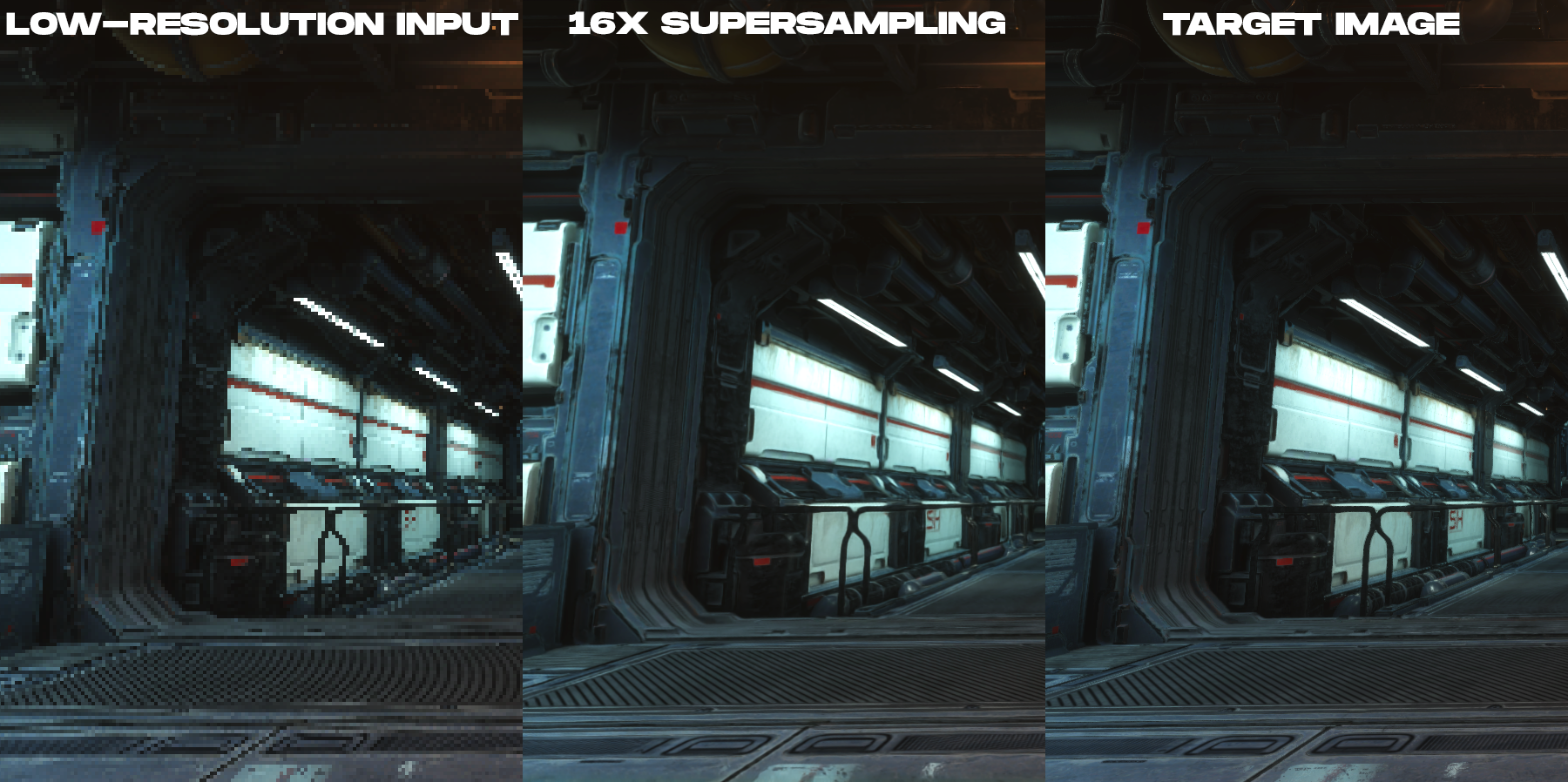

私たちのソリューションは、事前にトレーニングされたスーパーサンプリング手法であり、コンテンツの16倍のスーパーサンプリングを実現して、高い空間的および時間的忠実度でレンダリングし、以前の作業を大幅に上回ります。

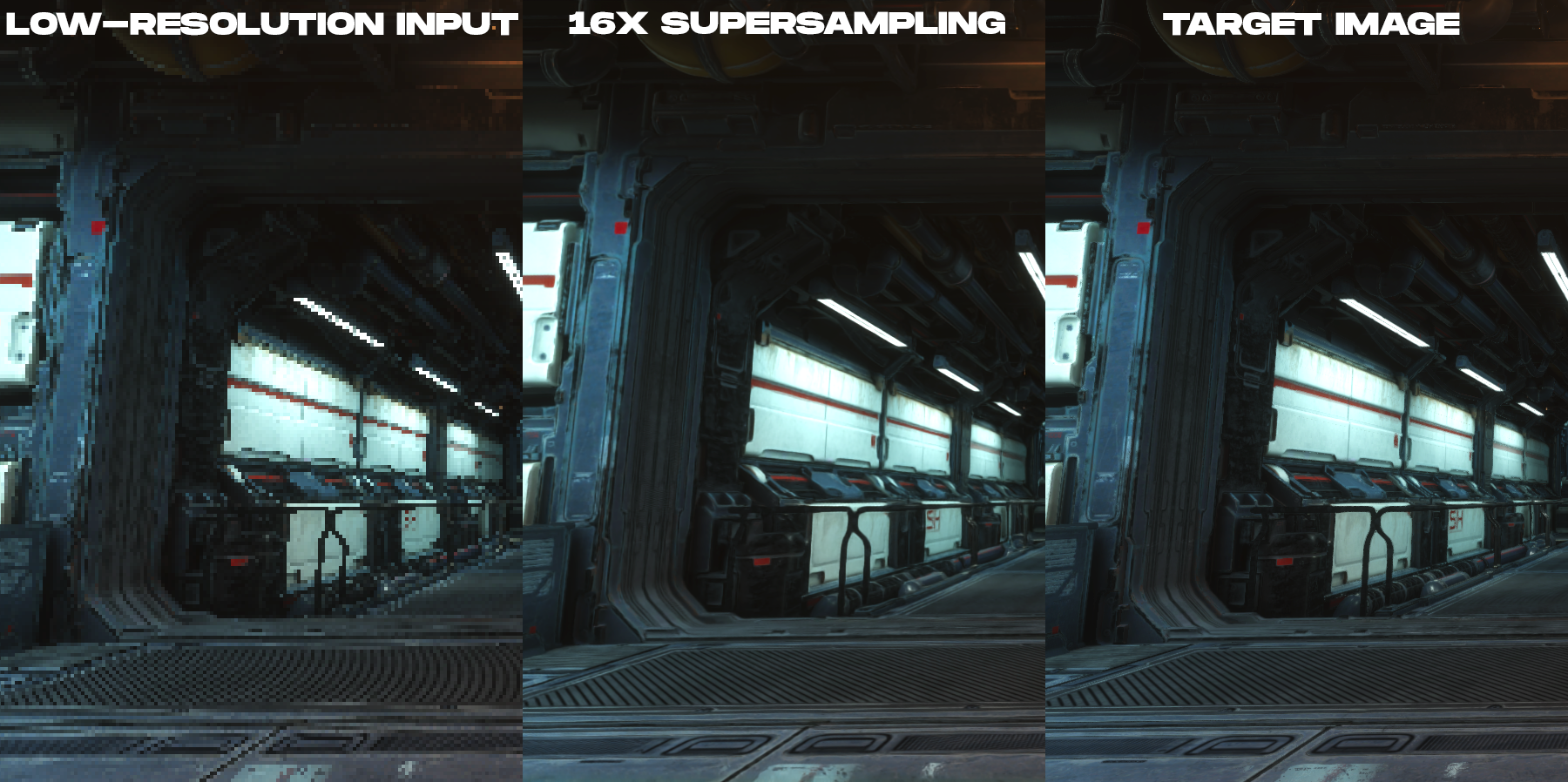

レンダリングされた低解像度のカラー画像と、新しいニューラルスーパーサンプリング技術によって作成された16倍のスーパーサンプリング出力画像を比較するためのアニメーション。

この研究は何についてですか?

高解像度ディスプレイでのレンダリングのコストを削減するために、この方法では、目的の出力画像の16分の1のピクセル数の入力画像を取得します。たとえば、ターゲットディスプレイの解像度が3840×2160の場合、ネットワークは960×540の入力画像サイズであるotrendernnogoゲームエンジンから開始し、リアルタイムの後処理でディスプレイの目的の解像度にアップサンプリングを実行します。

写真画像の学習ベースのアップサンプリングについては膨大な量の研究が行われていますが、この作業のすべてが、ビデオゲームエンジンによって生成された画像などのレンダリングされたコンテンツの固有のニーズに直接対処しているわけではありません。これは、レンダリングされた画像と写真画像の間に基本的な画像の違いがあるためです。リアルタイムレンダリングでは、各サンプルは空間と時間の両方のポイントです。このため、この投稿の低解像度の画像の例で見られるように、レンダリングされたコンテンツに深刻な歪み、ギザギザの線、およびその他のサンプリングアーティファクトが発生する傾向があります。このため、レンダリングされたコンテンツのアップサンプリングは、ノイズやブラーを排除するタスクではなく、アンチエイリアシングと補間の両方のタスクになります。これはコンピュータービジョンの専門家によってよく研究されています。入ってくる画像が非常に歪んでいて、ピクセルに補間するための情報がまったくないという事実は、時間的整合性を備えたレンダリングされたコンテンツの高精度の再構成を構築するのに重大な困難を生み出します。

, ( , ), .

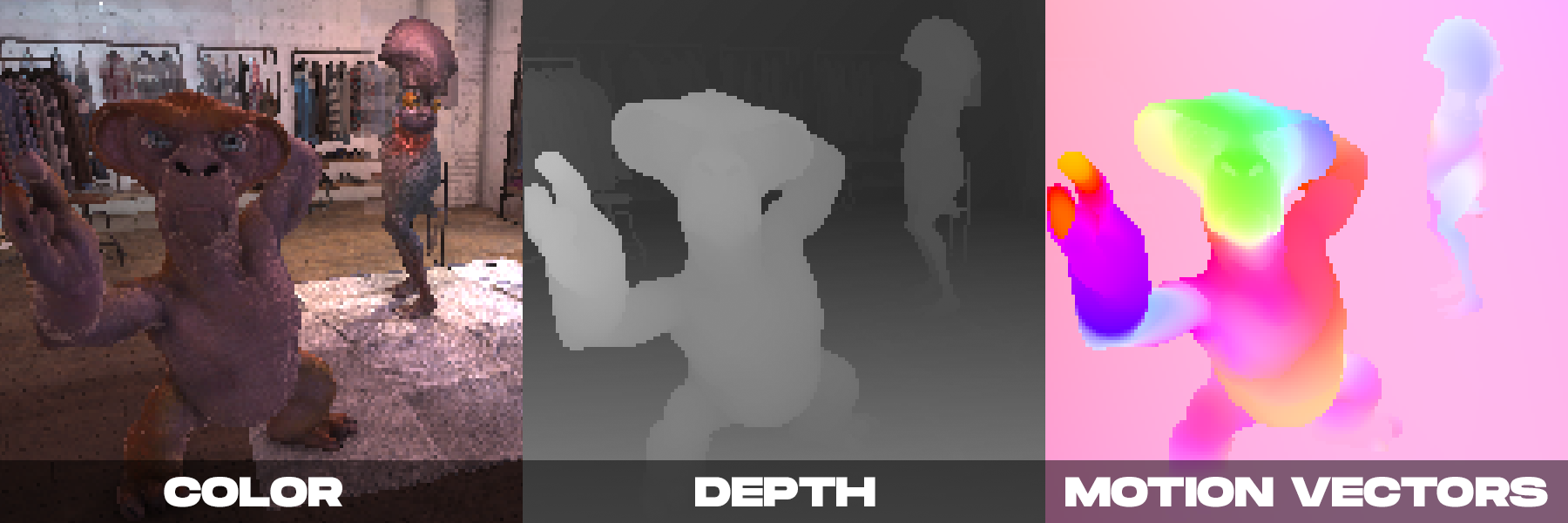

一方、リアルタイムでレンダリングする場合、カメラによって複数のカラー画像が生成される場合があります。 DeepFocusで示したように、最新のレンダリングエンジンは、深度値などの補助情報も提供します。ニューラルスーパーサンプリングでは、モーションベクトルによって提供される追加の補助情報が特に重要であることに気づきました。モーションベクトルは、連続するフレーム内のピクセル間の幾何学的関係を定義します。言い換えると、各モーションベクトルは、1つのフレームに表示されているサーフェスポイントが前のフレームにあった可能性があるサブピクセルの位置を指します。写真画像の場合、そのような値は通常、コンピュータービジョン法を使用して計算されますが、光学運動を計算するためのそのようなアルゴリズムはエラーが発生しやすいです。対照的に、レンダリングエンジンは高密度のモーションベクトルを直接作成できるため、レンダリングされたコンテンツに適用されるニューラルスーパーサンプリングに信頼性が高く十分な入力を提供します。

上記の観察に基づいて、私たちの方法は、追加の補助情報を、リアルタイムのパフォーマンスを提供しながら画像とビデオの品質を最大化するように設計された新しい時空間ニューラルネットワークスキームと組み合わせます。

決定を下すとき、私たちのニューラルネットワークは、低解像度でレンダリングされた現在のフレームと以前のいくつかのフレームの両方のレンダリング属性(各フレームの色、深度マップ、高密度モーションベクトル)を入力として受け取ります。ネットワークの出力は、現在のフレームに対応する高解像度のカラー画像です。ネットワークは監視された学習を使用します。トレーニング中、着信する各低解像度フレームで、アンチエイリアス方式の高解像度参照画像が照合されます。これは、トレーニング最適化のターゲット画像です。

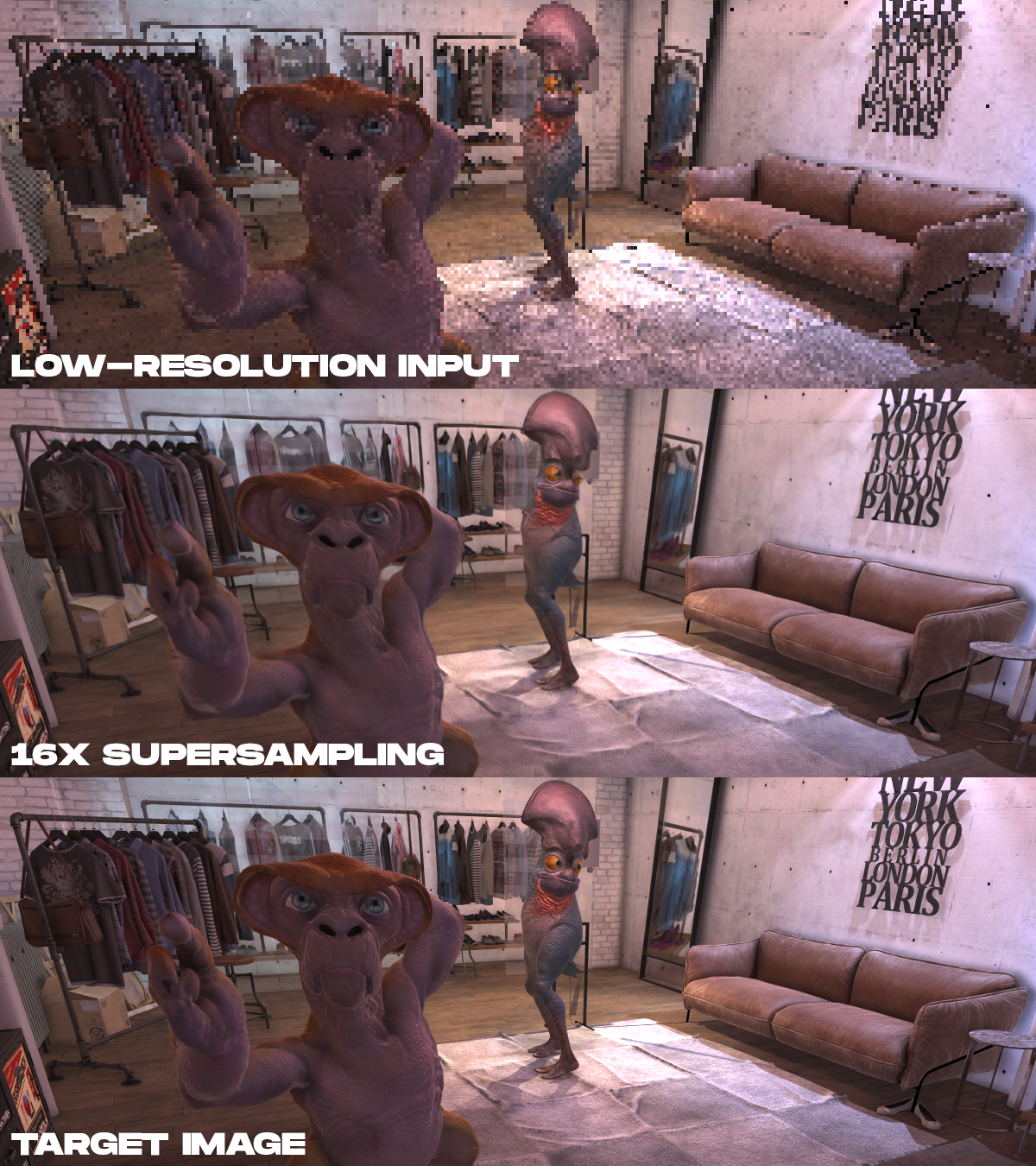

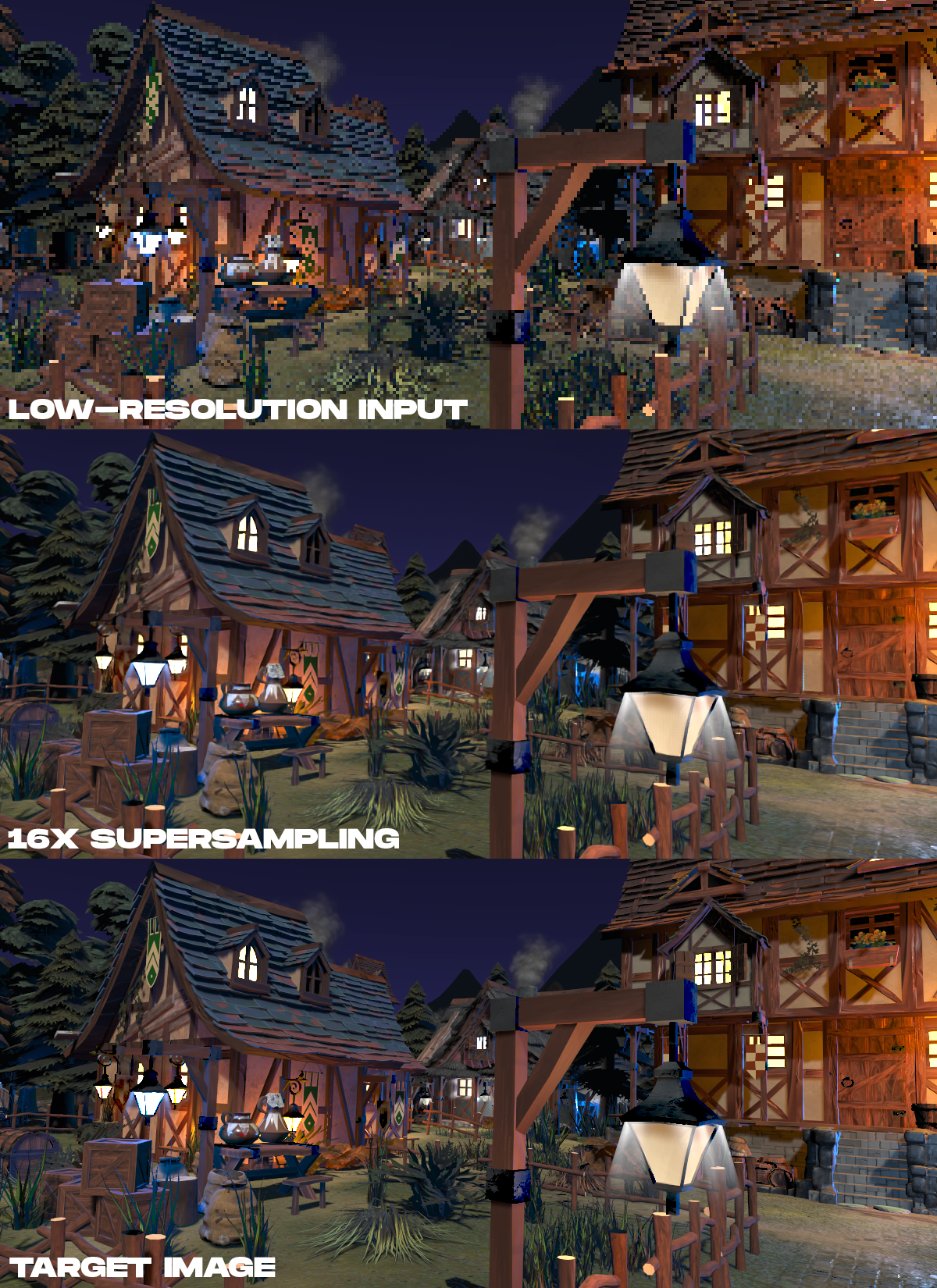

結果の例。上から順に、低解像度でレンダリングされた入力カラーデータ、提案された方法による16倍のスーパーサンプリングの結果、および非リアルタイムでレンダリングされた高解像度のターゲット画像が表示されます。

. , 16 , , , .

. , 16 , , , .

?

ニューラルレンダリングは、AR / VRで大きな可能性を秘めています。この作業は難しいですが、他の研究者にこのトピックに取り組むよう促したいと思います。AR / VRのディスプレイメーカーは、より高い解像度、より高いフレームレート、フォトリアリズムを追求しているため、ニューラルスーパーサンプリング技術は、直接レンダリングするのではなく、シーンデータから正確な詳細を復元するための重要な方法になる可能性があります。この作業により、高解像度VRの将来はディスプレイだけでなく、実際にそれらを駆動するために必要なアルゴリズムにもあることがわかります。

完全な技術記事:リアルタイムレンダリングのためのニューラルスーパーサンプリング、Lei Xiao、Salah Nouri、Matt Chapman、Alexander Fix、Douglas Lanman、Anton Kaplanyan、ACM SIGGRAPH2020。

参照: