2020年には、モバイルプラットフォームでの機械学習はもはや革命的ではありません。スマート機能のアプリケーションへの統合は、標準的な方法になっています。

幸いなことに、これはAppleが革新的なテクノロジーの開発をやめたことを意味するものではありません。

この投稿では、AppleエコシステムにおけるCoreMLプラットフォームおよびその他のAIおよびマシン学習テクノロジーに関するニュースを簡単に共有します。

コアML

昨年、CoreMLプラットフォームはメジャーアップデートを受け取りました。今年は、状況ははるかに控えめになりました。いくつかの新しいタイプのレイヤーが追加され、暗号化モデルがサポートされ、モデルの更新をCloudKitに投稿できるようになりました。

バージョン番号を削除することが決定されたようです。昨年の更新後、プラットフォームはCore ML 3として知られるようになりましたが、現在はバージョン番号なしでCoreMLという名前を使用しています。ただし、coremltoolsパッケージはバージョン4に更新されています。

注。mlmodelの内部仕様はバージョン5になりました。これは、新しいモデルが「CoreMLv5」という名前でNetronに表示されることを意味します。

CoreMLの新しいレイヤータイプ

次のレイヤーが追加されました。

Convolution3DLayer, Pooling3DLayer, GlobalPooling3DLayer: — Vision ( Core ML - , ).OneHotLayer: .ClampedReLULayer: ReLU ( ReLU6).- ArgSortLayer: . . , GatherLayer, argsort.

CumSumLayer: .SliceBySizeLayer:CoreMLではすでにいくつかのタイプの分割レイヤーが利用可能です。このレイヤーを使用すると、パーティションの開始元のインデックスを含むテンソルを渡すことができます。同時に、セクターサイズは常に固定されたままです。

これらのタイプのレイヤーは、バージョン5以降、つまりiOS14およびmacOS11.0以降で使用できます。

もう1つの便利な拡張機能:次のレイヤーの8ビット量子化操作:

InnerProductLayerBatchedMatMulLayer

Core MLの以前のバージョンでは、重みは量子化されていましたが、モデルをロードした後、浮動小数点形式に変換されました。新機能

int8DynamicQuantizeにより、重みを8ビットの整数値として保存し、整数を使用して実際の計算を実行することもできます。

INT8を使用した計算は、浮動小数点演算よりもはるかに高速です。これはCPUにいくつかの利点を提供しますが、フローティングポイント操作がGPUにとって非常に効率的であるため、GPUのパフォーマンスが向上するかどうかは不明です。おそらく、Neural Engineの将来のアップデートでは、INT8操作の組み込みサポートが実装される予定です(結局のところ、Appleは最近Xnor.aiを買収しました...)。

CPU側では、Core MLは32ビットではなく16ビットのフローティングポイントも使用できるようになりました(A11 Bionic以降)。ビデオ「Swiftでの数値計算の探索」で説明したように、Float16はSwiftのファーストクラスのデータタイプになりました。 16ビットフローティングポイント操作のネイティブサポートにより、CoreMLは速度を2倍にすることができます。

注。 Core MLでは、Float16データタイプはGPUとNeural Engineですでに使用されているため、CPUで使用した場合にのみ違いが顕著になります。

その他の(マイナーな)変更:

UpsampleLayer. BILINEAR ( align-corners). , , .-

ReorganizeDataLayerParamsPIXEL_SHUFFLE. , . , . -

SliceStaticLayerSliceDynamicLayersqueezeMasks, . -

TileLayer, .

デバイスでのローカル学習に関しては変更はないようです。それでも、完全に接続された畳み込みレイヤーのみがサポートされます。

MLParameterKeyCoreML.frameworkのクラスに、RMSpropオプティマイザの構成パラメータが含まれるようになりましたが、この拡張機能はまだNeuralNetwork.protoに含まれていません。おそらく、次のベータ版で追加されるでしょう。

次のモデルの新しい種類がされている追加:

VisionFeaturePrint.Object-物体認識用に最適化された特徴抽出部を。

SerializedModel..。これが何のためにあるのか正確にはわかりません。これは「非公開」の定義であり、「通知または責任なしに変更される可能性があります」。たぶんこれは、Appleが独自のモデル形式をmlmodelに埋め込む方法ですか?

モデルの更新をCloudKitに投稿する

この新しいCoreMLコンポーネントを使用すると、アプリケーションとは別にモデルを更新できます。

アプリケーション全体を更新する代わりに、デプロイされたインスタンスに新しいバージョンのmlmodelをロードするだけで済みます。正直なところ、このアイデアは新しいものではなく、一部のサードパーティベンダーはすでに対応するSDKを開発しています。その上、そのようなパッケージを自分で作成することは難しくありません。この場合のAppleのソリューションの利点は、AppleCloudでモデルをホストできることです。

アプリケーションは複数のモデルを持つことができるため、モデルのコレクションの新しい概念により、モデルを1つのパッケージにまとめて、アプリケーションがすべてのモデルを同時に更新できるようにすることができます。このようなコレクションは、CloudKitダッシュボードを使用して作成できます。

アプリケーションはクラスを使用して、モデルの更新をダウンロードおよび管理します

MLModelCollection。WWDCのビデオは、このタスクを達成するためにコードスニペットを示しています。

展開するコアMLモデルを準備するために、Xcodeで[モデルアーカイブの作成]ボタンが使用できるようになりました。それをクリックすると、.mlarchiveファイルに書き込まれます。このバージョンのモデルは、CloudKitダッシュボードに送信してから、モデルコレクションに追加できます(mlarchiveは、mlmodelcフォルダーの内容が追加された通常のZIPアーカイブのように見えます)。

さまざまなモデルのコレクションをさまざまなユーザーに展開できると非常に便利です。たとえば、iPhoneカメラはiPadカメラとは異なるため、モデルの2つのバージョンを作成し、1つをiPhoneユーザーに、もう1つをiPadユーザーに送信する必要がある場合があります。

さまざまなクラスのデバイス(iPhone、iPad、TV、Watch)、さまざまなオペレーティングシステムとそのバージョン、地域コード、言語コード、およびアプリケーションバージョンのカスタマイズルールを定義できます。

他の基準に基づいてユーザーをグループに分割するメカニズムはないようです。たとえば、モデルの更新のA / Bテストや、特定のデバイスタイプ(iPhone X以前)のチューニングなどです。ただし、これは、異なる名前でコレクションを作成し、から明示的に要求することにより、手動で行うことができます。

MLModelCollection実行時に指定された名前で適切なコレクションを提供します。

モデルの新しいバージョンの展開は必ずしも高速ではありません。ある時点で、アプリケーションは新しい利用可能なモデルを検出し、それを自動的にダウンロードしてアプリケーションのテスト環境に配置します。ただし、これがどこでどのように発生するかを判断する機能はありません。たとえば、電話を使用していないときに、CoreMLをバックグラウンドでダウンロードできます。

このため、すべての場合において、フォールバックとして組み込みモデルをアプリに追加することをお勧めします。たとえば、iPhoneとiPadの両方をサポートする汎用モデルです。

この便利なソリューションにより、ユーザーはセルフホスティングモデルについて心配する必要がなくなりますが、アプリケーションでCloudKitが使用されていることに注意してください。私が理解しているように、モデルコレクションは合計ストレージクォータにカウントされ、モデルロードはネットワークトラフィッククォータにカウントされます。

参照:

- モデルの展開とコアMLの保護(WWDCビデオ)

- モデルのコレクションの作成と展開

- 拡張モデルコレクションの取得

注。CloudKitを使用した新しい更新機能は、残念ながらローカルモデルのパーソナライズと組み合わせるのが非常に困難です。パーソナライズされたモデルによって得られた知識を新しいモデルに転送したり、何らかの方法でそれらを組み合わせたりする簡単な方法はありません。

モデルの暗号化

これまで、攻撃者はCore MLモデルを簡単に盗んで、独自のアプリケーションに統合することができました。iOS 14 / macOS 11.0以降、Core MLはモデルの自動暗号化と復号化をサポートし、攻撃者によるmlmodelcフォルダーへのアクセスを制限します。暗号化は、CloudKitを介して、または個別に、新しい展開機能と組み合わせて使用できます。

Xcodeは、元のmlmodelではなく、コンパイルされたモデル(mlmodelc)を暗号化します。モデルは常にユーザーのデバイスで暗号化されます。また、アプリケーションがモデルのインスタンスを作成する場合にのみ、CoreMLはそれを自動的に復号化します。モデルの復号化されたバージョンはメモリにのみ存在し、ファイルとして保存されません。

まず、暗号化キーが必要です。良いニュースは、このキーを自分で管理する必要がないことです。 [暗号化キーの作成]ボタンがCoreMLXcodeモデルビューアで使用できるようになりました(暗号化キーを作成します)。このボタンをクリックすると、Xcodeは新しい暗号化キーを生成し、それをApple開発チームアカウントに関連付けます。証明書の署名要求や物理アクセスキーを処理する必要はありません。

この手順により、新しい.mlmodelkeyファイルが作成されます。キーはAppleサーバーに保存されますが、Xcodeでモデルを暗号化するためのローカルコピーも取得します。この暗号化キーをアプリケーションに埋め込む必要はありません。特に、埋め込む必要がないためです。

Core MLモデルを暗号化する

--encrypt YourModel.mlmodelkeyために、そのモデルのコンパイラフラグを追加できます。また、CloudKitを使用してモデルを展開する場合は、モデルアーカイブを作成するときに暗号化キーを指定する必要があります。

アプリケーションがモデルをインスタンス化した後にモデルを復号化するには、CoreMLがネットワーク経由でAppleのサーバーから暗号化キーを取得する必要があります。もちろん、これにはネットワーク接続が必要です。 Core MLは、モデルを初めて使用するときにのみこの手順を実行します。

ネットワーク接続がなく、暗号化キーがまだロードされていない場合、アプリケーションはCoreMLモデルをインスタンス化できません。このため、新しい関数を使用することをお勧めします

YourModel.load()。これには、ダウンロードエラーに応答できる最終ハンドラーが含まれています。たとえば、エラーコードmodelKeyFetchは、CoreMLがAppleサーバーから暗号化キーをダウンロードできなかったことを示しています。

これは、誰かが特許技術を盗むことを心配している場合に非常に便利な機能です。さらに、アプリケーションへの統合も簡単です。

参照:

- モデルの展開とコアMLの保護(WWDCビデオ)

- モデル暗号化キーの生成

- アプリケーションでモデルを暗号化する

注。この開発者フォーラムの投稿で提供されている情報によると、暗号化されたモデルはローカルのパーソナライズをサポートしていません。合理的に聞こえます。

CoreML.framework

CoreMLモデルを操作するためのiOSAPIはそれほど変更されていません。それでも、いくつか興味深い点に注意したいと思います。

ここでの唯一の新しいクラスは

MLModelCollection、CloudKitで展開することを目的としたクラスです。

すでにご存知のように、mlmodelファイルをプロジェクトに追加すると、Xcodeは、モデルの操作を容易にするクラスを含むSwiftまたはObjective-Cソースファイルを自動的に生成します。これらの生成されたクラスにいくつかの変更があります。

-

init(). ,let model = YourModel().YourModel(configuration:)YourModel.load(), (, ). - ,

CVPixelBufferYourModelInput,CGImageURL-, PNG- JPG-, . ,cropAndScalecropRect. , , .

MLModelドキュメントに新しい警告 があり

ます。1つのスレッドまたは1つの送信キューでのみMLModelインスタンスを使用してください。これを行うには、モデルへのメソッド呼び出しをシリアル化するか、スレッドおよびディスパッチキューごとにモデルの個別のインスタンスを作成します。

あっ、すみません。 MLModel内では、リクエストの処理にシーケンシャルキューが使用されているように見えましたが、間違っているか、何かが変更されている可能性があります。いずれにせよ、将来的にはこの推奨事項に固執するのが最善です。実装された新しい初期化子

MLMultiArrayinit(concatenating:axis:dataType:)、既存の複数のマルチアレイを組み合わせて新しいマルチアレイを作成します。結合が実行される指定された軸を除いて、それらはすべて同じ形状である必要があります。この機能は、Create MLの新しいアクション分類モデルのように、ビデオデータから予測を行うために特別に追加されたようです。便利!

注。列挙

MLMultiArrayDataTypeに静的プロパティ.floatとが含まれるようになりました.float64。この列挙にはすでにプロパティ.float32とが含まれているため、それらが何のためにあるのか正確にはわかりません.double。ベータバグ?

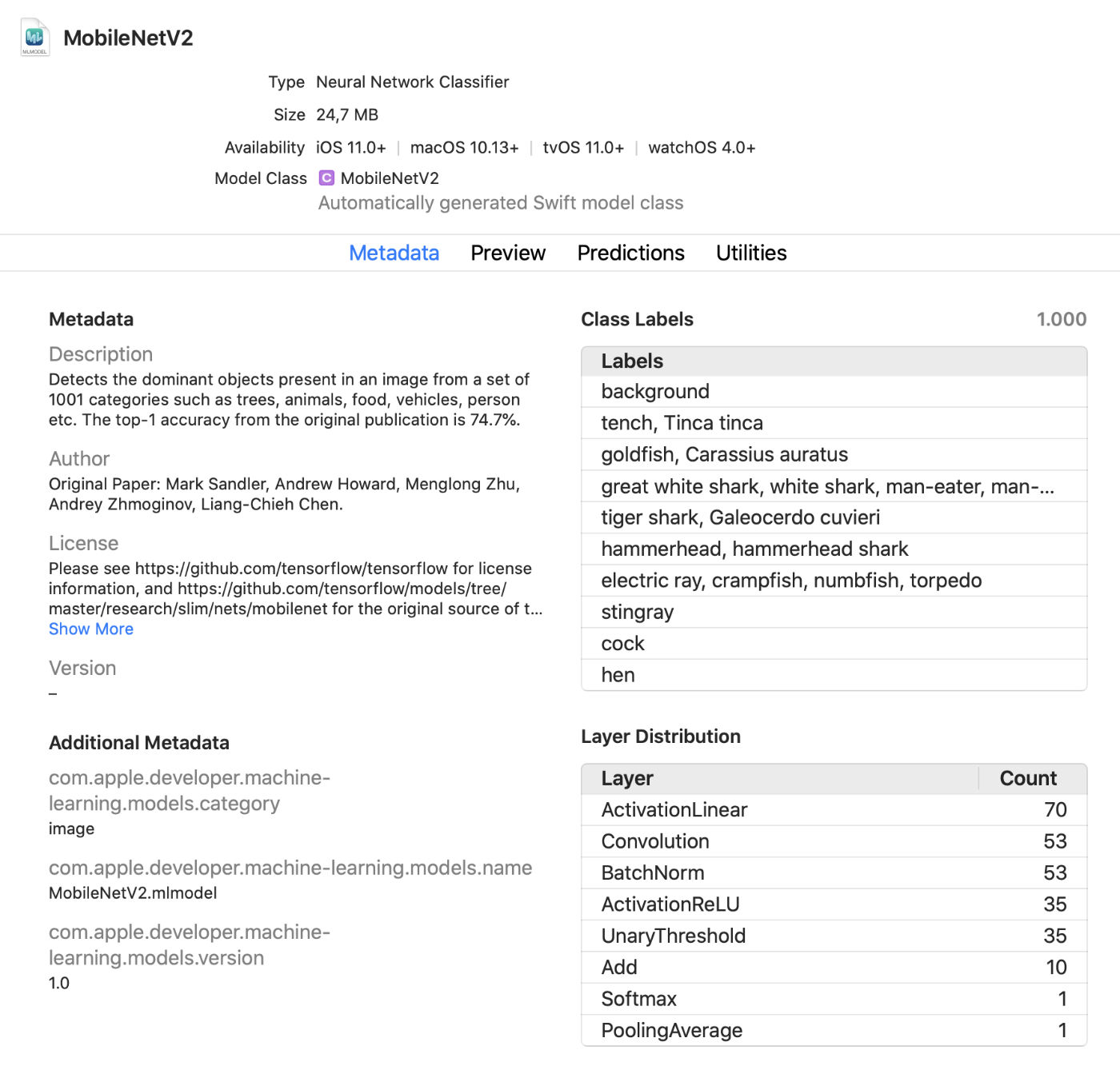

Xcodeモデルビューア

Xcodeは、クラスラベルや追加されたカスタムメタデータなど、モデルに関するより多くの情報を表示するようになりました。また、モデル内のレイヤーのタイプに関する統計も表示されます。

これは、アプリケーションを実行せずにテストモードでモデルに変更を加えることができる便利なライブビューアです。画像、ビデオ、またはテキストをこのプレビューウィンドウにドラッグして、モデルの予測をすぐに表示できます。素晴らしいアップデートです!

さらに、インタラクティブ環境でCoreMLモデルを使用できるようになりました。Xcodeは、このためのクラスを自動的に生成します。これは通常どおりに使用できます。これは、モデルをアプリケーションに追加する前に、モデルをインタラクティブにテストするもう1つの方法です。

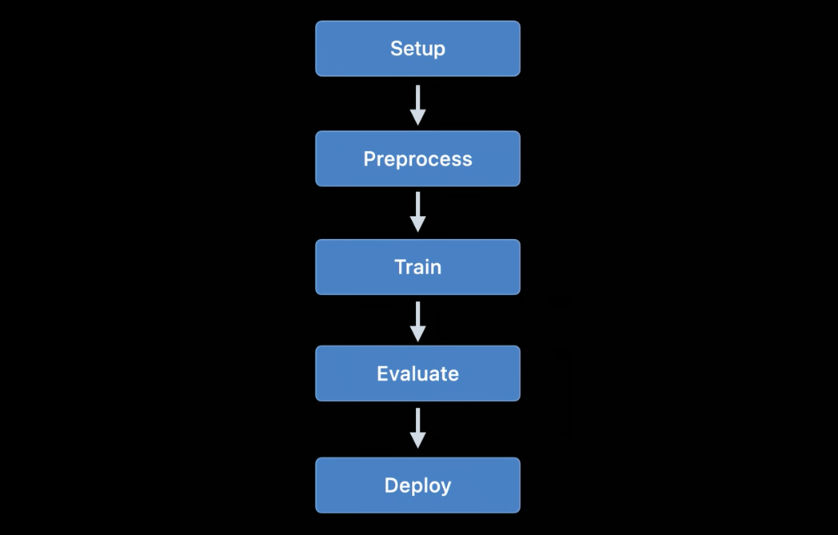

coremltools 4

Create MLを使用すると、単純なプロジェクト用に独自のモデルを作成すると便利ですが、トレーニングにはTensorFlowとPyTorchがより一般的に使用されます。 Core MLでこのようなモデルを使用するには、最初にモデルをmlmodel形式に変換する必要があります。これは、coremltoolsツールボックスが使用される目的です。

素晴らしいニュース:ドキュメントははるかに優れています。よく理解しておくことをお勧めします。ドキュメントが過去に常に最新であるとは限らなかったため、ユーザーマニュアルが定期的に更新されることを願っています。

注。残念ながら、サンプルのJupyterノートブックはなくなりました。これらは現在ユーザーマニュアルに含まれていますが、ノートブックとしては含まれていません。モデルを変換する方法が劇的に変化しました

..。以前に使用されていたニューラルネットワークコンバータは古く、より新しく、より柔軟なバージョンに置き換えられました。

現在利用可能なコンバーターには、次の3つのタイプがあります。

- TensorFlow(1.xと2.xの両方)、tf.keras、PyTorch用の最新のコンバーター。これらのコンバーターはすべて同じテクノロジーに基づいており、いわゆる中間モデル言語(MIL)を使用します。このようなモデルには、tfcoremlまたはonnx-coremlを使用する必要がなくなりました。

- Keras 1.x、Caffe、ONNXニューラルネットワーク用の古いコンバーター。それぞれに専用のコンバーターが用意されています。それらのさらなる開発は中止されており、将来的には修正のみが計画されています。PyTorchモデルの変換にONNXを使用することは推奨されなくなりました。

- scikit-learnやXGBoostなどの非ニューラルネットワークモデル用のコンバーター。

新しい統一変換APIを使用して、TensorFlow 1.x、2.x、PyTorch、またはtf.kerasモデルを変換します。それは次のように適用されます:

import coremltools as ct

class_labels = [ "cat", "dog" ]

image_input = ct.ImageType(shape=(1, 224, 224, 3),

bias=[-1, -1, -1],

scale=2/255.)

model = ct.convert(

keras_model,

inputs=[ image_input ],

classifier_config=ct.ClassifierConfig(class_labels)

)

model.save("YourModel.mlmodel")

この関数

ct.convert()は、モデルファイルをチェックしてその形式を決定し、適切なコンバーターを自動的に選択します。引数は以前に使用されたものとは少し異なります。前処理引数はオブジェクトを使用して渡されImageType、分類子ラベルはオブジェクトを使用して渡さClassifierConfigれます。

新しい変換APIは、モデルを中間表現(いわゆる)に変換します。MIL。現在、TensorFlow 1.xをMILに、TensorFlow 2.xをMIL(tf.kerasを含む)に、PyTorchをMILに変換するためのコンバーターが利用可能です。新しい深層学習プラットフォームが人気を博すと、MILへの独自のコンバーターを受け取ります。

モデルをMIL形式に変換した後、一般的なルールに従って最適化できます。たとえば、不要な操作を削除したり、いくつかの異なるレイヤーを組み合わせたりできます。次に、モデルがMILからmlmodel形式に変換されます。

これらすべてについてはまだ詳しく調べていませんが、新しいアプローチにより、coremtools4が以前よりも効率的なmlmodelファイルを作成できるようになることを期待しています。特にTF2.xグラフの場合はそうです。

MILでは、コンバーターがまだ分析していないレイヤーを処理できる機能が特に気に入っています。モデルにCoreMLで直接サポートされていないレイヤーが含まれている場合は、マトリックス乗算やその他の算術演算などのより単純なMIL演算にモデルを分割する必要がある場合があります。

その後、コンバーターは、このタイプのすべてのレイヤーに対して、いわゆる「複合操作」を使用できるようになります。これは、可能ですが、カスタムレイヤーを使用してサポートされていない操作を追加するよりもはるかに簡単です。ドキュメントは、そのような複合操作を使用する良い例を提供します。

参照:

機械学習を使用する他のAppleプラットフォーム

iOSおよびmacOSSDKの他のいくつかの高レベルフレームワークも、マシン学習タスクに使用されます。この分野の新機能を見てみましょう。

ビジョン

Visionコンピュータービジョンプラットフォームは、多くの新機能を備えています。

Visionプラットフォームは、顔、特徴的な機能、および人体を認識するためのモデルをすでに使用しています。新しいバージョンでは、次の機能が追加されています。

手の位置認識(

VNDetectHumanHandPoseRequest)複数人のポーズ

認識() AppleがOSにポーズ認識機能を組み込んだことは素晴らしいことです。いくつかのオープンソースモデルはこの機能をサポートしていますが、それらは効率的または高速にはほど遠いです。商用ソリューションは高価です。高品質のポーズ認識ツールが無料で利用できるようになりました! 現在、静止画像を表示するのとは対照的に、より多くの注意が払われています

VNDetectHumanBodyPoseRequest

オフラインとリアルタイムの両方でのビデオ録画上のオブジェクトの認識。便宜上、

CMSampleBufferリクエストハンドラーを使用してカメラから直接オブジェクトを使用できます。

また、

VNImageBasedRequestサブクラスがクラスVNStatefulRequestに追加されました。このサブクラスは、目的のオブジェクトの検出を迅速に確認する役割を果たします。標準クラスとは異なり、VNImageBasedRequest複数のフレームにまたがるステートフルクエリを再利用します。このリクエストは、ビデオのNフレームごとに分析を実行します。

検索オブジェクトが見つかると、オブジェクトを含む最終ハンドラーが呼び出されます

VNObservation。このハンドラーにはtimeRange、ビデオでの観測の開始時刻と停止時刻を示すプロパティがあります。

クラスは直接

VNStatefulRequest使用されません。これは抽象基本クラスであり、現在VNDetectTrajectoriesRequest、パス認識の目的でクエリによってのみサブクラス化されています。これにより、ボールを投げたり蹴ったりするときなど、放物線状のパスに沿って移動する形状を認識できます(これは現時点で唯一の組み込みのビデオ関連タスクのようです)。

オフラインビデオ分析の場合、

VNVideoProcessor.このオブジェクトを使用できます。ローカルビデオにURLを追加し、NフレームまたはN秒ごとに1つ以上のVision要求を行います。

ビデオ録画を分析するための最も重要な従来のコンピュータービジョン技術の1つは、光の流れです。..。

VNGenerateOpticalFlowRequest各ピクセルが1つのフレームから別のフレームに移動する方向を計算するクエリがVisionで利用できるようになりました(高密度の光の流れ)。その結果、VNPixelBufferObservation各ピクセルが2つの32ビットまたは16ビットの浮動小数点値に対応する新しい画像を含むオブジェクトが作成されます。

さらに、画像内のオブジェクト

VNDetectContoursRequestの輪郭を認識するための新しいクエリが追加されました。このようなパスは、ベクトルパスとして返されます。VNGeometryUtils認識された輪郭をさらに処理するための補助ツールを提供します。たとえば、基本的な幾何学的形状に単純化します。

そして、Visionの最後の革新は、組み込みの機能抽出機能VisionFeaturePrintの新しいバージョンです。 IOSはすでにブロックを実装していますVisionFeaturePrint.Scene。これは、画像分類子の作成に特に便利です。さらに、新しいVisionFeaturePrint.Objectモデルが利用可能になりました。これは、オブジェクト認識で使用される機能を強調表示するように最適化されています。

このモデルは299x299の入力画像をサポートし、それぞれ形状(288、35、35)と(768、17、17)の2つのマルチアレイを返します。これはまだ明確な制限フレームワークではなく、「生の」機能のみです。本格的なオブジェクト認識を行うには、これらの機能を境界ボックスとクラスラベルに変換するロジックを追加する必要があります。トレーニング転送を使用してオブジェクト認識ツールをトレーニングしている場合、CreateMLはこのタスクを実行します。

参照:

- Computer Vision APIの調査(WWDCビデオ)

- ビジョンで体と手のポーズを検出する(WWDCビデオ)

- Action&Visionアプリを探索する(WWDCビデオ)

自然言語処理

自然言語処理タスクには、NaturalLanguageプラットフォームを使用できます。彼女はCreateMLでトレーニングされたモデルを積極的に使用しています。

今年追加された新機能はほとんどありません。

NLTaggerそしてNLModel今、複数のタグを見つけて、それらの有効性を予測します。以前は、タグの有効性は、得点されたポイントの数によってのみ決定されていました。- 文章を挿入する。以前は単語の挿入を使用できましたが、現在

NLEmbeddingは全文をサポートしています。

センテンスを挿入する場合、組み込みのニューラルネットワークを使用してセンテンス全体を512次元のベクトルにエンコードします。これにより、文で単語が使用されているコンテキストを取得できます(単語の挿入はこの機能をサポートしていません)。

参照:

- Natural Language(WWDCビデオ)でアプリをよりスマートに

音声と音声の分析

この領域に変更はありませんでした。

モデルトレーニング

Apple APIを使用したトレーニングモデルは、iOS11.3およびMetalPerformanceShadersプラットフォームで最初に利用可能になりました。過去数年間で、多くの新しいトレーニングAPIが追加され、今年も例外ではありませんでした。私の計算によると、iOSおよびmacOSプラットフォームでニューラルネットワークをトレーニングするための7つの異なるAPIがあります。

現在、次のApple APIを使用して、iOSおよびmacOSでマシン学習モデル(特にニューラルネットワーク)をトレーニングできます。

- CoreMLでのローカル学習。

- MLの作成:このインターフェイスはアプリケーションとして知られているかもしれませんが、macOSで利用できるプラットフォームでもあります。

- Metal Performance Shaders:GPUでの推論とトレーニングのためのAPI。実際、これらは2つの異なるAPIであり、Metalを初めて使用する場合は使用するのが非常に困難です。さらに、これらのレガシーAPIに取って代わるように見える新しいMetal Performance ShadersGraphフレームワークも利用できます。

- BNNS:Accelerateプラットフォームの一部。以前は、BNNSで使用できるのは推論ルーチンのみでしたが、今年はトレーニングサポートも追加されました。

- ML Compute:非常に有望に見える根本的に新しいプラットフォーム。

- Turi Create:これは実際にはCreateMLのPythonバージョンです。プラットフォームのサポートはまだ終了していませんが、最近、その作成者はそれを忘れています。

これらのAPIの革新を詳しく見てみましょう。

CoreMLでのローカル学習

実際、ここでは大きな変更はありません。さらにいくつかのレイヤータイプに更新サポートが追加されている可能性がありますが、これに関するドキュメントはまだ見ていません。

将来のベータ版で期待される重要な革新の1つは、RMSpropオプティマイザーです。現在のベータ版には含まれていません。

MLを作成する

Create MLプラットフォームは、当初macOSでのみ利用可能でした。 Swift Playgroundで実行できるため、わずか数行のコードでモデルをトレーニングできます。

昨年、Create MLはかなり限定されたアプリケーションに変換されましたが、今年は大幅な改善が見られたことを嬉しく思います。そうは言っても、Create MLは、コードビハインドから引き続き使用できるプラットフォームのままです。実際、このアプリケーションは、プラットフォームを操作するための便利なグラフィカルインターフェイスにすぎません。

以前のバージョンのCreateMLでは、モデルを1回だけトレーニングできました。何かを変更するには、最初から再トレーニングする必要があり、これには多くの時間がかかりました。

Xcode12の新しいバージョンではトレーニングを一時停止して後で再開し、モデルのチェックポイント(スナップショット)を保存して、モデルのトレーニング結果のプレビューを表示します。現在、学習プロセスを管理するためのツールが大幅に増えています。今回のアップデートで、Create MLは本当に便利です!

CreateML.frameworkプラットフォームでは、トレーニングセッションの設定、モデルブレークポイントの処理など、新しいAPIも利用できます。ほとんどの人はCreate MLアプリケーションを使用するだけだと思いますが、この機能がプラットフォームで利用できるようになったことはすばらしいことです。

新しいCreateML機能(プラットフォームとアプリの両方):

- 写真やビデオのスタイルを転送する

- ビデオにおける人間の行動の分類

新しいアクション分類モデルを詳しく見てみましょう。 Visionプラットフォームで利用可能な姿勢認識モデルを使用します。アクション分類子は、入力として(

window_size, 3, 18)の形式をとるニューラルネットワークであり、最初の値はフレーム数で示されるビデオフラグメントの期間を表し(通常は約2秒のフラグメントが使用されます)、(3、18)はポーズの要点を表します。

レイヤーを繰り返す代わりに、ニューラルネットワークは1次元の畳み込みを使用します。これは、時系列予測用に特別に設計されたモデルの一種である時空間グラフ畳み込みネットワーク(STGCN)のバリエーションである可能性があります。これらの詳細は、アプリケーションでそのようなモデルを使用するときに心配する必要はありません。しかし、私は常にそれがどのように機能するかを知りたいです。

オブジェクト認識モデルについては、TinyYOLOv2に基づいてネットワーク全体をトレーニングするか、新しいVisionFeaturePrint.Objectフィーチャ抽出ユニットを使用する新しいトレーニング転送モードを使用するかを選択できます。モデルの残りの部分はまだYOLOとSSDに似ていますが、転送のおかげで、そのトレーニングはYOLOベースのモデル全体をトレーニングするよりもはるかに高速になります。

参照:

- Create MLを使用してアクション分類子を作成する(WWDCビデオ)

- Create ML(WWDCビデオ)で画像およびビデオスタイル転送モデルを構築する

- Control training in Create ML with Swift ( Create ML Swift) ( WWDC)

Metal Performance Shaders

Metal Performance Shaders(MPS)は、Metalのパフォーマンスコンピューティングコアに基づくプラットフォームであり、主に画像処理に使用されますが、2016年以降はニューラルネットワークもサポートしています。私はこれについてすでにたくさんブログを書いています。

今日、ほとんどのユーザーはMPSではなくCoreMLを選択します。もちろん、Core MLは、GPUでモデルを実行するときに、MPSの能力を引き続き使用します。ただし、特にユーザーが自分でトレーニングを実施する場合は、MPSを直接使用することもできます(ちなみに、MPSの代わりに使用することをお勧めする新しいプラットフォームML Computeが利用可能になりました。その説明を以下に示します)。

今年のMPSCNNにはいくつかの新機能がありますが、既存の機能にいくつかの改善が加えられています。

新しいクラスを追加しました

MPSImageCannyエッジ認識用およびラインセグメント認識用のMPSImageEDLines。これらは、コンピューターのビジョンの問題に取り組むときに非常に役立ちます。

他の多くの変更も注目に値します。

MPSCNNConvolutionDataSource新しいプロパティが追加されていkernelWeightsDataTypeますが、畳み込みのために使用されるよりも重み係数の異なるデータ型を使用することを可能にすること。興味深いことに、Core MLではこのデータタイプを個々のレイヤーに使用できますが、重みをINT8データタイプにすることはできません。- が

kernelWeightsDataType返される場合.float32、畳み込み層と完全に接続された層は、16ビットではなく32ビットの浮動小数点を使用して実行されます。以前は、16ビットのみがサポートされていました。 - 損失関数でパラメーターを使用できるようになりました

reduceAcrossBatch。

Metalがあなたを怖がらせないのであれば、MPSCNNを引き続き使用できます。ただし、このようなグラフの作成と実行を大幅に簡素化する新しいプラットフォーム、MPSグラフが利用可能になりました。

注。WWDCのビデオがMPSNDArrayが新しいAPIであると述べているが、実際にそれが昨年出てきました。モデル内のすべてのテンサーを画像にできるわけではないため、MPSImageよりもはるかに柔軟なデータ構造です。

New:メタルパフォーマンスシェーダーグラフ

APIはMPS

MPSNNGraphで長い間利用可能でしたが、実際、そのようなグラフはニューラルネットワークのみを記述しています。ただし、すべてのグラフがニューラルネットワークである必要はありません。この場合、Metal Performance ShadersGraphプラットフォームが役立ちます。

この新しいプラットフォームを使用して、汎用GPU計算グラフを作成できます。 MPS Graphプラットフォームは、それに基づいて構築されていますが、Metal PerformanceShadersに依存していません。

廃止されたAPIの以前のバージョンでは

MPSNNGraph、グラフにカスタム操作を追加することはできませんでした。新しいプラットフォームは、この点ではるかに柔軟性があります。ただし、独自のメタルコアを追加することはできません。既存のプリミティブを使用してすべての計算を表現する必要があります。

幸いなことにコンパイラ

MPSGraphこのようなプリミティブの単一の計算コアへの統合をサポートし、グラフィックプロセッサで最も効率的な作業を保証します。ただし、提供されたプリミティブを一部の操作に使用することが不可能または困難な場合、このスキームは機能しません。 Appleがこのような新しいAPIを作成するときに、本格的なカスタム関数を作成する機能を提供しない理由がわかりません。しかし、何もできません。

新しいプラットフォーム

MPSGraphは、MPSGraphOperationsテンサーを使用してセット内の操作間の関係を記述する、かなり単純で論理的な構造です。MPSGraphTensors操作の結果が含まれています。さらに、制御の依存関係を定義して、個々のノードを他のノードよりも先に開始するように強制できます。グラフを構成した後、グラフを実行するか、コマンドバッファーに転送して、結果を待つ必要があります。

MPSGraphグラフに数学またはニューラルネットワーク操作を追加できるようにするインスタンスメソッドのセット全体を提供します。

さらに、トレーニングがサポートされています。これには、損失処理操作をグラフに追加してから、従来のレイヤーとは逆の順序ですべてのレイヤーの勾配操作を実行することが含まれます

MPSNNGraph。便宜上、自動微分モードも使用できます。このモードではMPSGraph、グラフの勾配操作が自動的に実行されます。これにより、多くの労力を節約できます。

このような計算グラフを作成するための、新しくシンプルでわかりやすいAPIが登場したことを嬉しく思います。以前のバージョンよりもはるかに使いやすいです。そして、あなたはそれを扱うために金属の専門家である必要はありません。ちなみに、TensorFlow 1.xのグラフによく似ていますが、最適化という点で大きなメリットがあり、コストを最小限に抑えることができます。それでも、グラフに任意の計算コアを追加する十分な機会はありません。

参照:

BNNS(基本的なニューラルネットワークサブルーチン)

Core MLがCPUで実行されている場合、Accelerateプラットフォームの一部であるBNSSルーチンを使用します。私はすでにこの記事でBNNSについて書いています。これらのBNNS機能のほとんどは現在、ほとんど廃止され、新しい機能セットに置き換えられています。

以前は、完全に接続されたレイヤー、折りたたみ、グループ化、およびアクティブ化機能のみがサポートされていました。このアップデートでは、n次元アレイ、ほぼすべてのタイプのCore MLレイヤー、およびそのようなトレーニングレイヤーの下位互換性バージョン(LSTMなどの現在Core MLトレーニングをサポートしていないレイヤーを含む)のサポートがBNNSに追加されます。複数の注意の

層の存在にも注目する価値があります。..。これらのレイヤーは、BERTなどのTransformerモデルでよく使用されます。もう1つの興味深い点は、テンソルコンボリューションです。

GPUトレーニングにMPSを使用しないのと同じように、これらのBNNS機能を自分で使用していない可能性があります。代わりに、使用されるプロセッサを抽象化する、より高いレベルのMLComputeプラットフォームが利用可能になりました。ML ComputeはBNNSとMPSに基づいていますが、開発者はそのような小さなことについて心配する必要はありません。

参照:BNNSプラットフォームのドキュメント

新規:MLコンピューティング

ML Computeは、CPUまたはGPUでニューラルネットワークをトレーニングするための根本的に新しいプラットフォームです(ただし、明らかに、Neural Engineプロセッサではありません)。複数のGPUを備えたMacProでは、このプラットフォームはそれらすべてを自動的に使用してトレーニングできます。

別の学習プラットフォームの存在に少し驚いたが、このプラットフォームを使用すると、低レベルのコンポーネントをBNNSとMPSから、そして将来的にはNeural Engineから隠すことができるため、すべてが本当に簡素化されます。

何よりも、ML Computeは、MacだけでなくiOSシステムでもサポートされています。 CoreMLがどこにも言及されていないのはおかしいです。 ML Computeは、完全に別個に作成されたようです。このフレームワークを使用してコアMLモデルを作成することはできません。

私自身の経験から、ML Computeのタスクは、まず第一に、サードパーティの深層学習ツールの作業をスピードアップすることであると言えます。 ML Computeを直接操作するために、コードを記述する必要はありません。 TensorFlowなどのツールがこのプラットフォームを使用してMacでハードウェアアクセラレーションによる学習サポートを有効にすることが想定されている(または開発者が望んでいる)ようです。

BNNSとほぼ同じレイヤーのセットを使用できます。レイヤーをグラフに追加してから実行する必要があります(ここでは、「ビジー待機」モードは使用されません)。

グラフを作成するには、最初にオブジェクト

MLCGraphをインスタンス化し、それにノードを追加する必要があります。ノードはサブクラスMLCLayerです。ノードはオブジェクトを介して相互に接続されていますMLCTensor他のレイヤーの出力が含まれています。

興味深いことに、分割、連結、再フォーマット、および転送の操作は、別々のタイプのレイヤーではなく、グラフ上で直接操作されます。

優れたデバッグ機能-

summarizedDOTDescription。グラフのDOT記述を返し、そこから、たとえばGraphvizまたはOmniGraffleを使用してグラフを作成できます(ちなみに、Kerasはこの方法でモデルグラフを生成します)。

ML Computeは、推論グラフと学習グラフを区別します。後者には、損失レイヤーやオプティマイザーなどの追加のノードが含まれます。

カスタムレイヤーを作成する方法はないようです。そのため、MLComputeで使用可能なタイプを使用するだけで済みます。

この新しいプラットフォームにWWDCセッションがなかったのは不思議であり、ドキュメントもかなり散らばっています。とにかく、これはAppleデバイスでのモデルのトレーニングに最適なAPIであると思われるため、今後も開発を続けていきます。

参照:ML ComputePlatformドキュメント

結論

コアMLは、そのようなモデルや暗号化の自動更新など便利な新機能の数を追加しました。昨年追加されたレイヤーはほとんどすべての問題を解決できるため、新しいレイヤータイプは実際には必要ありません。全体的に、私はこのアップデートが好きです。

でcoremltools 4つの添加重要な改善-新しいコンバータアーキテクチャ及びビルトインサポートTensorFlow 2及びPyTorch。 PyTorchモデルを変換するためにONNXを使用する必要がなくなったことを嬉しく思います。

インビジョン多くの新しい便利な機能が追加されました。そして、Appleがビデオ分析機能を追加したことを気に入っています。機械学習システムはビデオの個々のフレームに適用できますが、この場合、時間は考慮されません。モバイルデバイスは現在、ビデオデータに基づいてリアルタイムで機械学習を実行するのに十分な速度であるため、近い将来、ビデオがコンピュータビジョンテクノロジーの開発においてより重要な役割を果たすと思います。トレーニング

に関して...このタスクに7つの異なるAPIが必要かどうかはわかりません。新しいインターフェースが完全に洗練されるまで、Appleは古いインターフェースを廃止したくなかったと思います。MLComputeプラットフォームについてはほとんど知られていません。ただし、この記事の執筆時点では、最初のベータ版のみがリリースされています。誰が先にあるのかを知っています...

講義の写真はflaticon.comのFreepikアイコンを使用しています。